Teknolojideki yeni tehlike: Deepfake

Derin sahte anlamına gelen “Deepfake” teknolojisi, bir başkasına ait ses ve videoyu birebir aynı şekilde kopyalayarak çeşitli sahtecilik ve dolandırıcılıklarda kullanılmasına olanak sağlıyor.

Google News'te Doğruhaber'e abone olun.

Google News'te Doğruhaber'e abone olun. Deepfake teknolojisi ve tehlikeleri hakkında İLKHA’ya açıklama yapan Van Yüzüncü Yıl Üniversitesi Fen Bilimleri Enstitüsü Yapay Zeka Anabilim Dalı yüksek lisans öğrencisi Levent Dalgın, Deepfake kavramının ilk kez 2017 yılında popüler olmaya başladığını, tanım olarak bakıldığında “Derin sahte” anlamına geldiğini ve derin bir video manipülasyon işlemi olduğuna dikkat çekti.

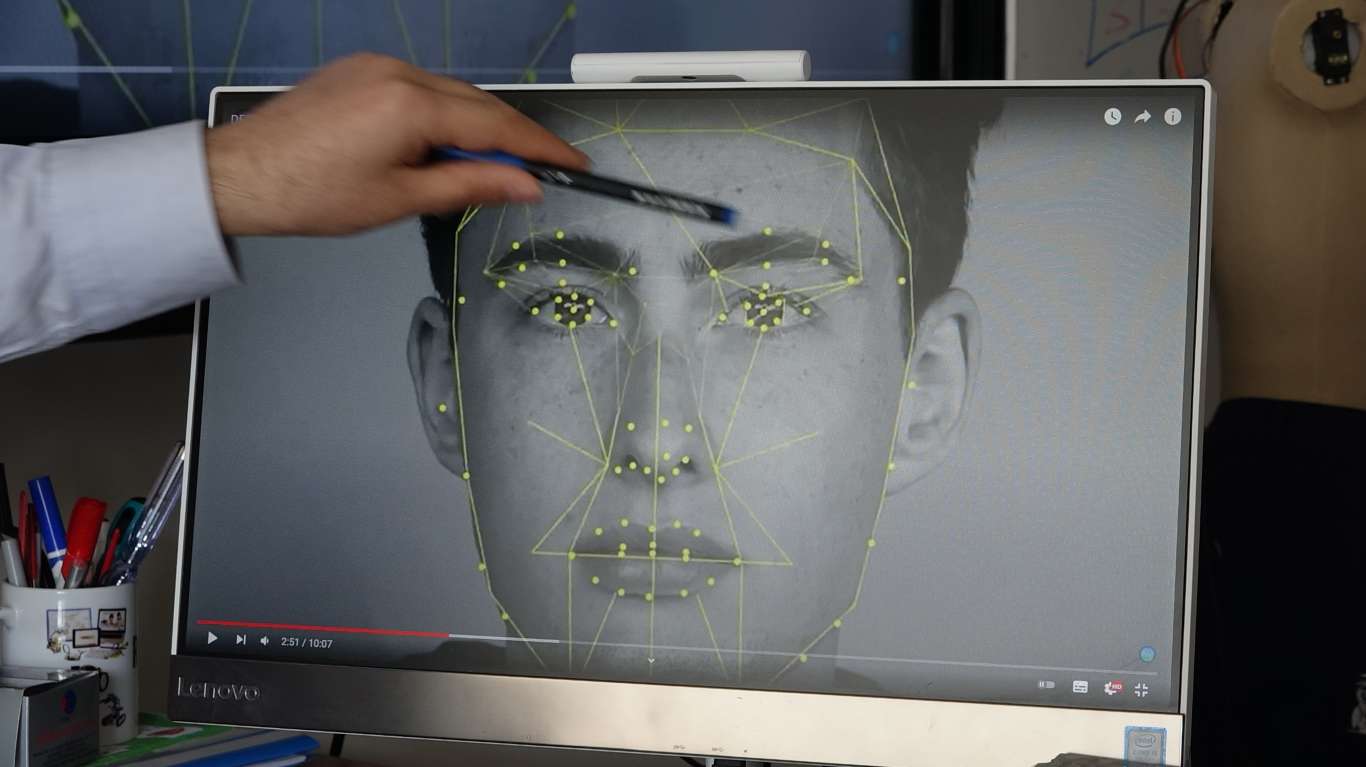

Dalgın “Bu işlem, Deepfake yapılmak istenen ünlü kişi veya hedef kişinin yüzü başka birinin yüzündeki ifadeler referans alınarak politikacının, sanatçının veya hedef kişinin yüzüne monte edilmesidir. Bu görsel ve işitsel bir manipülasyon işlemidir diyebiliriz. Yüzündeki ifadeleri kopyalıyorsunuz. Siz konuştukça, bir şeyler ifade ettikçe sizin yüzünüzdeki mimikler, jestler hedef kişinin yüzündeki jest ve mimiklerle yer değiştiriyor ve o hedef kişi söylemediği bir şeyi söylemiş gibi görünüyor.” dedi.

“Fotoğraf ne kadar çok açıdan alınırsa o kadar kaliteli çıktı elde edilir”

Deepfake teknolojisini yapay zeka teknolojisi ile olan ilişkisini anlatan Dalgın, şunları söyledi:

“Yapay zekâda machine learning (ML) denilen bir olay var. Yani makine öğrenme dediğimiz bir olay var. Aynı zamanda bizim burada görüntü işleme kütüphaneleri var, nesneler ile ilgili işlemler var. Bu yaptığımız işlemlerde, biz resimleri bilgisayara eğittiriyoruz. Yani yapay zekâ resimleri eğitiyor, eğitim ve test modellerini ortaya çıkarıyor. Bu şekilde resimler arasında karşılaştırma yapıyor. Deepfake konusunda da benzer bir şey söz konusu. Deepfake’de aldığınız hedef kişinin, sanatçının, politikacının veya bir komedyenin videolarını, fotoğraflarını alıyorsunuz. Ne kadar çok açıdan fotoğraf alabilirseniz fotoğrafları yapay zekâ ile eğittiğiniz zaman o kadar kaliteli bir çıktı elde edebilirsiniz.

Örneğin ünlü Komedyen Jordan Peele’nin yaptığı bir çalışma vardı. Barack Obama’nın yüzünü taklit etmişti. Yaklaşık 500 tane fotoğraf almıştı, bunların eğitimi yaklaşık 100 saat sürmüştü ve sonuçta bir dakikalık çok kaliteli bir sonuç çıkmıştı ortaya. Videoyu ilk kez izleyen insanlar çok şaşırmıştı. Çünkü video neredeyse Barack Obama’nın birebir aynısıydı. Barack Obama’nın sesi, melodisi, jest ve mimikleri birebir kopyalanmıştı. Yapay zekâ teknolojisi burada aldığı fotoğrafları ve videoları işliyor. Yani eğitiyor.

Deepfake teknolojisinin isminden yola çıkarsak derin sahtecilik olayında olmayan bir şeyi olmuş gibi gösteriyorsunuz. Barack Obama’nın o sahte açıklaması başta gerçekmiş gibi yansıtıldı sonradan Komedyen Jordan Peele sahneye gelerek bunun bir Deepfake videosu olduğunu söylüyor. İnsanlar çok şaşırıyor. Söylemediği bir sözü söylemiş gibi gösteriyorlar. Tabi sansasyonel bir habere yol açabiliyor.”

“Deepfake teknolojisi kullanılarak bir şirket 243 bin dolarlık zarara uğratıldı”

Levent Dalgın

İngiltere merkezli bir şirketin Deepfake kandırmacası ile yaklaşık 243 bin dolarlık zarara uğratıldığını ifade eden Dalgın, “Şirketin üst ceosu alt ceosunu arıyor. Yaklaşık bir saatlik bir röportaj gerçekleşiyor ve para transferi gerçekleşiyor. Yaklaşık 243 bin dolar para transferi sağlanıyor. Sonrasında alt firmanın ceosu açıklama yapıyor. Diyor ki benimle bir saat konuştu, tamamen bir Alman aksanı ile görüştü ve sesteki tonlama, melodiler tamamen aynıydı. Paranın takibini yapıyorlar. Para başta bir bankaya havale ediyorlar daha sonra birçok kullanıcıya dağıtılıyor ve takibi imkânsız hale geliyor. Bu şekilde bir maddi zarar ortaya çıkıyor. Yine karşılaştığımız facebook ve bazı tiktok videolarında insanlar biranda sahte bir video ile karşılaştıklarında yanılgı içine girebiliyorlar. Bu şekilde dolandırıcılık ve sahtecilik vakaları yaşanabiliyor. Bunlara dikkat etmek gerekiyor. Bir video ile karşılaştığımızda ya da bir arama gerçekleştirildiğinde iki defa düşünmek gerek ve kaynağını tespit etmek gerekiyor.” ifadelerini kullandı.

“Duyduğumuz, gördüğümüz videoları mutlaka teyit ettirelim”

Beklenmeyen videolar ve konuşmaların mutlaka doğru kaynaktan teyit ettirilmesi gerektiğinin altını çizen Dalgın, şunları söyledi:

“Duyduğumuz veya gördüğümüz videoların kaynağını teyit ettirmemiz gerekiyor. Çünkü Deepfake videoları biranda yayılabiliyor. Bir politikacıdan hiç beklemediğimiz bir açıklama duyabiliriz. Sevdiğimiz birinden gelen telefonla sarsılabiliriz. Hemen bunu teyit ettirmek gerekiyor. Bizi arayan kişiyi arayıp konuşmaları teyit ettirebiliriz. Çünkü telefonlar da kopya edilebiliyor. Yani sevdiğimiz birinin telefonundan aranmış gibi yanıltılabiliriz. Sesler, tonlamalar, melodiler tamamen birebir kopyalanabiliyor. Sese inanmazsınız ama kişinin birkaç fotoğrafı alınıp yapay zekâ teknolojisi ile eğitildikten sonra onunla da aldatılabilirsiniz. O yüzden duyduğumuz, gördüğümüz haberleri mutlaka doğru kaynaktan teyit ettirilmeli ki istenmeyen bir durumla karşılaşılmasın.

Teknoloji hızla ilerliyor. Yapay zekâ teknolojileri gün geçtikçe daha da yaygınlaşıp popüler hale geliyor. Aslında Deepfake başta eğlence amacıyla ortaya çıktı. İnsanlar bir komedyenin yüzünü kendi yüzüne monte ederek eğleniyorlardı. Ama faydaları ile beraber bu şekilde zararları da olabiliyor. Bunlara mutlaka dikkat etmek gerekiyor.” (İLKHA)